Bonjour,

Depuis hier, je ne parviens plus à lancer JupyterLab. J'ai fait plusieurs tentatives en vain.

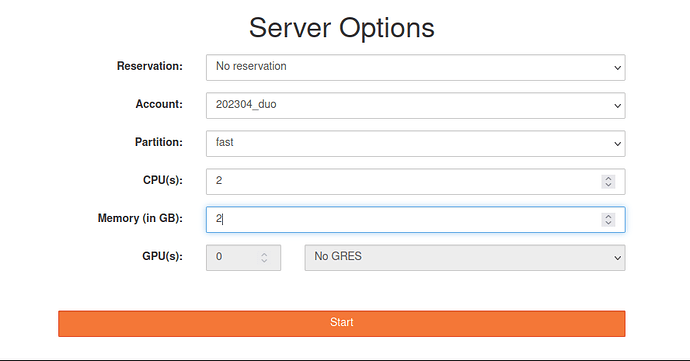

Je demande pourtant des ressources raisonnables sur un account valable :

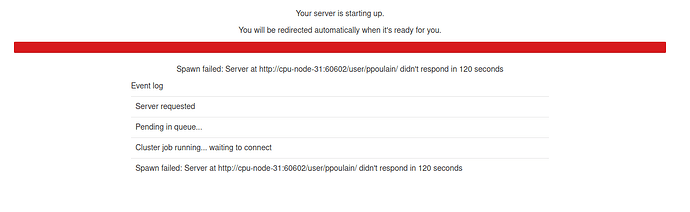

Mais au bout de quelque temps, j'obtiens le message suivant :

J'avais lu dans un précédent fil de discussion que supprimer ~/.local/share/jupyter/ pouvait aider. C'est ce que j'ai fait, sans résultat probant.

Curieusement cela semble remarcher. Par exemple avec le job 33338546 sur le noeud cpu-node-17.

Pourriez-vous à tout hasard vérifier l'état de santé du noeud cpu-node-31 ?

D'avance merci.

Pierre

Bonjour,

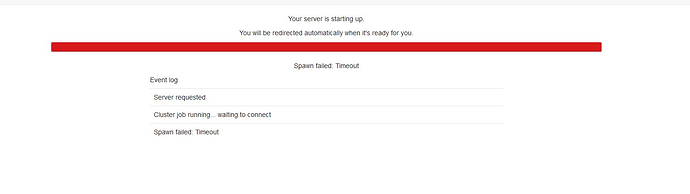

Je rencontre le même problème de connexion impossible à JupyterLab, avec un message d'erreur un peu différent :"Spawn failed : Timeout".

J'ai également fait le test sur des projets distincts, sur la partition fast et long, avec des ressources minimales ou plus importantes, j'ai aussi déplacé le dossier ~/.local/share/jupyter/ sans succès.

Les jobs correspondants sont tous en statut "FAILED", mais sur des nodes distincts (cpu-node-67, cpu-node-31, cpu-node-35, cpu-node-17).

Merci de vos lumières

Pascal

@team.ifbcorecluster une idée du souci ? Est-ce lié à certains noeuds en particulier ?

Bonjour,

Je pense que c'est lié à une charge importante ponctuelle sur le cluster.

JupyterHub patiente 120 secondes jusqu'à ce que le job qu'il a soumis au cluster démarre. Si le cluster est très chargé et n'a pas suffisamment de ressources disponibles pour démarrer le job alors l'erreur que vous rencontrez va se produire.

Nous allons prochainement renforcer les ressources du cluster (+4000 cœurs et +32To de RAM) et nous allons également tenter de réserver des ressources pour les usages interactifs comme JupyterLab.

Julien

Bonjour et merci pour la réponse rapide !

Ce qui me chiffonne est que dans mes tests, dès que je tente de démarrer une session JLab, un job est quasi immédiatement en statut Running via sacct, puis en 4-6 secondes passe en Failed. Est-ce que ça suggère qu'il y a dans ces cas là des slots dispo (à l'instant par ex j'ai demandé 1 cpu et 1Go), que le job est lancé mais pour une raison inconnue le job crash très vite ?

Aussi serait-il possible de réduire le temps de 120 secondes dans l'interface web JLab avant d'avoir le message d'erreur, idéalement pas beaucoup plus longtemps que le job qui fail dans les secondes qui suivent la soumission (théoriquement faisable j'imagine, mais bien sûr à voir si c'est implémentable en pratique).

Bonjour Pascal,

Si le job associé à la session JupyterLab plante alors il s'agit d'un autre problème...

Je constate effectivement que pour vous le job démarre puis crash après quelques secondes.

J'en déduis que le process JupyterLab lancé par JupyterHub plante quelques secondes après avoir démarré...

Est-ce que vous faites un usage particulier de JupyterLab (utilisation de kernel perso, autres paramétrages) ?

En attendant, je vais essayer de tracer l'erreur, je reviens vers vous dès que j'ai trouvé quelques choses.

Julien

J'ai trouvé.

Vous avez atteint de le quota d'inodes (100000) sur votre home directory.

SLURM ne parvient pas a créer son fichier de sortie en démarrant la session JupyterLab et le job crash immédiatement.

Il va falloir réduire le nombre de fichier dans votre home pour que SLURM puisse à nouveau fonctionner correctement.

Pour consulter le quota de votre homedir :

lfs quota -h -p 160909 /shared/home/phingamp

Julien

1 « J'aime »

Merci Julien !

Je confirme que le problème s'est résolu dès lors que mon home est repassé sous le quota en terme de nombre de fichiers.

Comme j'ai eu du mal à comprendre comment diable je pouvais avoir "138202" fichiers dans mon home dans lequel je ne stocke pourtant pas grand chose (700Mo dans 2176 fichiers perso), au cas où ça arrive à d'autres, voici où j'ai fini par mettre la main sur plus de 130000 fichiers planqués installés à mon insu par je ne sais quelle manip j'ai dû faire par le passé (30000 à 50000 fichiers par répertoire):

.local/share/jupyter

.julia

.cache/yarn/

Donc réglé par un triple rm -rf qui a pris des plombes

J'oubliais de dire que c'est une super nouvelle

C'est prévu à quelle échéance ?

Fin juin, début juillet !

1 « J'aime »

D'accord, merci pour ta réponse. Mais comment dans ce cas expliquer le fait que le message d'erreur mentionne un noeud en particulier (dans la copie d'écran cpu-node-31) si le job jupyterlab n'a pas eu le temps partir ?

@julien un des usagers du projet est victime du même symptôme (impossibilité de démarrer une session JupyterLab, cf capture d'écran ci-dessous), mais dans son cas n'a pas dépassé ses quotas:

lfs quota -h -p `id -u $USER` /shared/ifbstor1

Disk quotas for prj 164262 (pid 164262):

Filesystem used quota limit grace files quota limit grace

/shared/ifbstor1

937.7M 100G 150G - 55446 100000 150000 -

Ses tentatives de lancements se traduisent visiblement systématiquement par un statut "CANCELLED" au bout de 5 minutes :

$ sacct --format=JobID%20,JobName%18,Partition,ReqCPUS,ReqMem,Timelimit,State,ExitCode,Start,elapsed,CPUTime,MaxRSS -S 2023-05-01

JobID JobName Partition ReqCPUS ReqMem Timelimit State ExitCode Start Elapsed CPUTime MaxRSS

-------------------- ------------------ ---------- -------- ---------- ---------- ---------- -------- ------------------- ---------- ---------- ----------

33194151 jupyter fast 1 1Gn 12:00:00 TIMEOUT 0:0 2023-05-03T08:41:57 12:00:06 12:00:06

33194151.batch batch 1 1Gn CANCELLED 0:15 2023-05-03T08:41:57 12:00:08 12:00:08 7844K

33194151.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-03T08:41:58 12:00:13 12:00:13 372416K

33313581 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T07:47:16 00:04:59 00:04:59

33313581.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T07:47:16 00:05:00 00:05:00 7848K

33313581.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T07:47:17 00:05:01 00:05:01 102580K

33313602 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T07:53:48 00:05:00 00:05:00

33313602.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T07:53:48 00:05:01 00:05:01 7848K

33313602.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T07:53:49 00:05:02 00:05:02 101184K

33313957 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:01:57 00:04:59 00:04:59

33313957.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:01:57 00:05:00 00:05:00 7848K

33313957.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:01:59 00:05:00 00:05:00 103828K

33316150 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:11:08 00:05:00 00:05:00

33316150.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:11:08 00:05:01 00:05:01 7848K

33316150.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:11:09 00:05:02 00:05:02 101696K

33318031 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:19:06 00:05:00 00:05:00

33318031.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:19:06 00:05:02 00:05:02 7844K

33318031.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:19:07 00:05:03 00:05:03 103940K

33318380 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:26:48 00:04:59 00:04:59

33318380.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:26:48 00:05:00 00:05:00 7848K

33318380.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:26:50 00:05:00 00:05:00 101284K

33318445 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:33:40 00:04:59 00:04:59

33318445.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:33:40 00:05:00 00:05:00 7848K

33318445.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:33:40 00:05:02 00:05:02 102424K

33319058 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T10:11:24 00:04:59 00:04:59

33319058.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T10:11:24 00:05:00 00:05:00 7852K

33319058.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T10:11:25 00:05:02 00:05:02 103036K

33339560 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T08:24:48 00:05:00 00:05:00

33339560.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T08:24:48 00:05:01 00:05:01 7856K

33339560.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T08:24:50 00:05:07 00:05:07 102996K

33339696 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T08:30:23 00:05:00 00:05:00

33339696.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T08:30:23 00:05:01 00:05:01 7852K

33339696.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T08:30:25 00:05:07 00:05:07 102812K

33340417 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T08:52:52 00:05:00 00:05:00

33340417.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T08:52:52 00:05:02 00:05:02 7856K

33340417.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T08:52:54 00:05:07 00:05:07 103216K

33341126 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T09:45:25 00:04:59 00:04:59

33341126.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T09:45:25 00:05:00 00:05:00 7848K

33341126.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T09:45:26 00:05:01 00:05:01 101868K

33344327 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T11:26:34 00:04:59 00:04:59

33344327.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T11:26:34 00:05:01 00:05:01 7844K

33344327.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T11:26:35 00:05:02 00:05:02 101368K

33418514 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-15T08:01:16 00:04:59 00:04:59

33418514.batch batch 1 1Gn CANCELLED 0:15 2023-05-15T08:01:16 00:05:00 00:05:00 7848K

33418514.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-15T08:01:17 00:05:01 00:05:01 101312K

33418965 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-15T08:56:37 00:04:59 00:04:59

33418965.batch batch 1 1Gn CANCELLED 0:15 2023-05-15T08:56:37 00:05:08 00:05:08 7828K

33418965.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-15T08:56:38 00:05:09 00:05:09 101420K

Votre aide est la bienvenue !

Pour info, @julien a résolu ce dernier problème en écartant deux répertoires cachés dans le "home" de l'utilisateur qui interféraient avec JupyterLab: .local .ipython (renommés ou supprimés selon votre degré de confiance que vous n'en aurez plus besoin).

1 « J'aime »