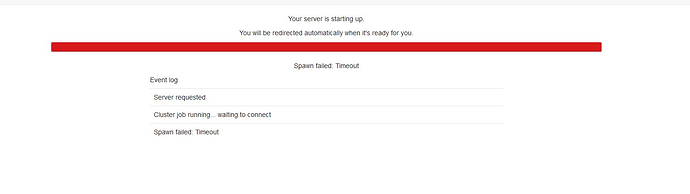

@julien un des usagers du projet est victime du même symptôme (impossibilité de démarrer une session JupyterLab, cf capture d'écran ci-dessous), mais dans son cas n'a pas dépassé ses quotas:

lfs quota -h -p `id -u $USER` /shared/ifbstor1

Disk quotas for prj 164262 (pid 164262):

Filesystem used quota limit grace files quota limit grace

/shared/ifbstor1

937.7M 100G 150G - 55446 100000 150000 -

Ses tentatives de lancements se traduisent visiblement systématiquement par un statut "CANCELLED" au bout de 5 minutes :

$ sacct --format=JobID%20,JobName%18,Partition,ReqCPUS,ReqMem,Timelimit,State,ExitCode,Start,elapsed,CPUTime,MaxRSS -S 2023-05-01

JobID JobName Partition ReqCPUS ReqMem Timelimit State ExitCode Start Elapsed CPUTime MaxRSS

-------------------- ------------------ ---------- -------- ---------- ---------- ---------- -------- ------------------- ---------- ---------- ----------

33194151 jupyter fast 1 1Gn 12:00:00 TIMEOUT 0:0 2023-05-03T08:41:57 12:00:06 12:00:06

33194151.batch batch 1 1Gn CANCELLED 0:15 2023-05-03T08:41:57 12:00:08 12:00:08 7844K

33194151.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-03T08:41:58 12:00:13 12:00:13 372416K

33313581 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T07:47:16 00:04:59 00:04:59

33313581.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T07:47:16 00:05:00 00:05:00 7848K

33313581.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T07:47:17 00:05:01 00:05:01 102580K

33313602 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T07:53:48 00:05:00 00:05:00

33313602.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T07:53:48 00:05:01 00:05:01 7848K

33313602.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T07:53:49 00:05:02 00:05:02 101184K

33313957 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:01:57 00:04:59 00:04:59

33313957.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:01:57 00:05:00 00:05:00 7848K

33313957.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:01:59 00:05:00 00:05:00 103828K

33316150 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:11:08 00:05:00 00:05:00

33316150.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:11:08 00:05:01 00:05:01 7848K

33316150.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:11:09 00:05:02 00:05:02 101696K

33318031 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:19:06 00:05:00 00:05:00

33318031.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:19:06 00:05:02 00:05:02 7844K

33318031.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:19:07 00:05:03 00:05:03 103940K

33318380 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:26:48 00:04:59 00:04:59

33318380.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:26:48 00:05:00 00:05:00 7848K

33318380.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:26:50 00:05:00 00:05:00 101284K

33318445 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T08:33:40 00:04:59 00:04:59

33318445.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T08:33:40 00:05:00 00:05:00 7848K

33318445.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T08:33:40 00:05:02 00:05:02 102424K

33319058 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-09T10:11:24 00:04:59 00:04:59

33319058.batch batch 1 1Gn CANCELLED 0:15 2023-05-09T10:11:24 00:05:00 00:05:00 7852K

33319058.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-09T10:11:25 00:05:02 00:05:02 103036K

33339560 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T08:24:48 00:05:00 00:05:00

33339560.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T08:24:48 00:05:01 00:05:01 7856K

33339560.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T08:24:50 00:05:07 00:05:07 102996K

33339696 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T08:30:23 00:05:00 00:05:00

33339696.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T08:30:23 00:05:01 00:05:01 7852K

33339696.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T08:30:25 00:05:07 00:05:07 102812K

33340417 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T08:52:52 00:05:00 00:05:00

33340417.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T08:52:52 00:05:02 00:05:02 7856K

33340417.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T08:52:54 00:05:07 00:05:07 103216K

33341126 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T09:45:25 00:04:59 00:04:59

33341126.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T09:45:25 00:05:00 00:05:00 7848K

33341126.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T09:45:26 00:05:01 00:05:01 101868K

33344327 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-10T11:26:34 00:04:59 00:04:59

33344327.batch batch 1 1Gn CANCELLED 0:15 2023-05-10T11:26:34 00:05:01 00:05:01 7844K

33344327.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-10T11:26:35 00:05:02 00:05:02 101368K

33418514 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-15T08:01:16 00:04:59 00:04:59

33418514.batch batch 1 1Gn CANCELLED 0:15 2023-05-15T08:01:16 00:05:00 00:05:00 7848K

33418514.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-15T08:01:17 00:05:01 00:05:01 101312K

33418965 jupyter fast 1 1Gn 12:00:00 CANCELLED+ 0:0 2023-05-15T08:56:37 00:04:59 00:04:59

33418965.batch batch 1 1Gn CANCELLED 0:15 2023-05-15T08:56:37 00:05:08 00:05:08 7828K

33418965.0 batchspawner-sing+ 1 1Gn COMPLETED 0:0 2023-05-15T08:56:38 00:05:09 00:05:09 101420K

Votre aide est la bienvenue !