Bonjour,

Depuis plusieurs jours je n'arrive pas à lancer de session JupyterHub depuis la nouvelle page ondemand.cluster.... . Ca marchait presque instantanément avec le système précédent, là je n'ai réussi qu'une seule fois mais récemment rien. J'ai essayé différentes quantités de mémoire et de CPU et après "Starting" je finis toujours par avoir : "Your session has entered a bad state. Feel free to contact support for further information". C'est pareil avec fast et long, et je ne demande pas de GPU. Si je lance un job sur fast avec slurm ça passe pourtant tout de suite.

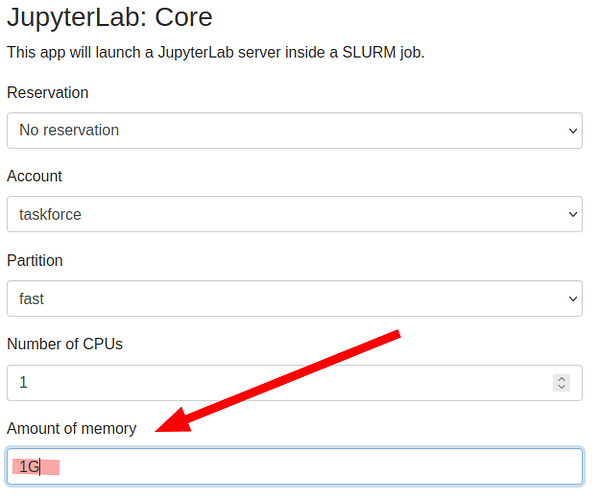

Après l'échec de JupyterLab, dans "output.log" j'ai (même en demandant un seul Go de mémoire) :

Script starting...

Waiting for Jupyter Notebook server to open port 26367...

TIMING - Starting wait at: Tue Mar 19 22:16:15 CET 2024

TIMING - Starting main script at: Tue Mar 19 22:16:15 CET 2024

Currently Loaded Modulefiles:

- jupyterlab/3.5.0

TIMING - Starting jupyter at: Tue Mar 19 22:16:15 CET 2024

- jupyter lab --config=/shared/home/dcros/ondemand/data/sys/dashboard/batch_connect/sys/jupyter/core/output/c9223c3a-0b06-4043-aeae-5c81612ce4e3/config.py --FileContentsManager.delete_to_trash=False

/shared/home/dcros/ondemand/data/sys/dashboard/batch_connect/sys/jupyter/core/output/c9223c3a-0b06-4043-aeae-5c81612ce4e3/script.sh: line 27: 46038 Killed jupyter lab --config="${CONFIG_FILE}" --FileContentsManager.delete_to_trash=False

Timed out waiting for Jupyter Notebook server to open port 26367!

TIMING - Wait ended at: Tue Mar 19 22:17:25 CET 2024

Cleaning up...

slurmstepd: error: Detected 1 oom-kill event(s) in StepId=38472920.batch. Some of your processes may have been killed by the cgroup out-of-memory handler.

Merci

David